آنتروپیک، توسعهدهنده مدل هوش مصنوعی کلود، در تغییری مهم اعلام کرد که از این پس مکالمات و کدهای کاربران را برای بهبود و آموزش مدلهای آینده خود استفاده خواهد کرد، مگر اینکه کاربران صراحتاً مخالفت کنند.

این شرکت سیاستهای خود را بهروزرسانی کرده تا اجازه استفاده از دادههای کاربران برای آموزش مدلها را داشته باشد و دوره نگهداری این دادهها برای کاربرانی که موافقت کنند به پنج سال افزایش یافته است. این تغییر نگرانیهایی درباره حریم خصوصی و نحوه کسب رضایت کاربران ایجاد کرده است.

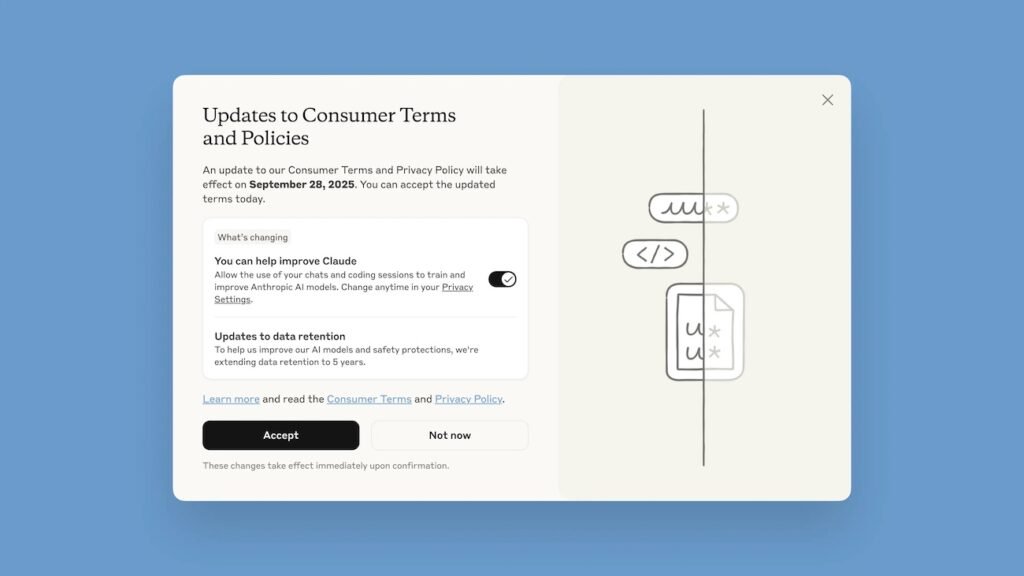

کاربران هنگام ورود به چتبات کلود با یک پنجره پاپآپ با عنوان «بهروزرسانی شرایط و سیاستهای مصرفکننده» مواجه میشوند که باید تا ۶ مهر ۱۴۰۴ (۲۸ سپتامبر ۲۰۲۵) تصمیم خود را مشخص کنند. طراحی این پنجره انتقاداتی را به دنبال داشته است. دکمه برجسته «پذیرش» در پایین صفحه قرار دارد، در حالی که گزینه مربوط به اجازه استفاده از دادهها با فونت کوچکتر و بهصورت کلید روشن/خاموش در زیر آن قرار گرفته و بهطور پیشفرض روی حالت «روشن» تنظیم شده است. این طراحی ممکن است باعث شود بسیاری از کاربران بدون توجه به جزئیات، با کلیک روی دکمه «پذیرش» ناخواسته با اشتراک دادهها موافقت کنند.

برای جلوگیری از استفاده مکالمات در آموزش هوش مصنوعی، کاربران باید کلید مربوطه را خاموش کرده و سپس دکمه پذیرش را انتخاب کنند. در صورت موافقت اشتباه، میتوان از طریق بخش تنظیمات، قسمت حریم خصوصی و گزینه «Help improve Claude» این تنظیم را غیرفعال کرد. این تغییر تنها روی دادههای آینده اعمال میشود و دادههای قبلی استفادهشده قابل بازگشت نیستند.

این سیاست جدید شامل کاربران اشتراکهای مصرفکننده کلود (رایگان، پرو و مکس) میشود، اما کاربران تجاری، سازمانی (مانند Claude for Work و Education) و کسانی که از طریق API شرکتهایی مانند Amazon Bedrock یا Google Cloud به کلود دسترسی دارند، مشمول آن نمیشوند.

این سیاست تنها به مکالمات جدید یا مکالمات قدیمی که از سر گرفته شوند اعمال خواهد شد و مکالمات قبلی تا زمانی که ادامه پیدا نکنند، برای آموزش استفاده نمیشوند.

آنتروپیک اعلام کرده که هدف این تغییر، توسعه مدلهای هوش مصنوعی قویتر و کاربردیتر است که به بهبود ایمنی، شناسایی دقیقتر محتوای مضر و تقویت مهارتهایی مانند کدنویسی و تحلیل کمک میکند. این شرکت تأکید کرده که با استفاده از ابزارها و فرآیندهای خودکار، دادههای حساس را فیلتر یا مخفی میکند و دادههای کاربران را به اشخاص ثالث نمیفروشد. کاربرانی که با اشتراک دادهها موافقت نکنند، تحت سیاست قبلی باقی میمانند و دادههایشان پس از ۳۰ روز حذف خواهد شد.